Table of Contents

¿Cuántas veces has buscado en Google este año? ¿menos que el año pasado? Desde luego que menos desde la llegada de ChatGPT.

Lo que antes era una búsqueda en Google, leer varias páginas y tenías tu respuesta ha cambiado. Ahora delegamos muchas de esas consultas en ChatGPT, Gemini, Perplexity…

Muchos de los que estáis leyendo esto antes de ChatGPT seguro que hacíais consultas en Stack Overflow. ¿Quién consulta ahora allí si ya lo hace ChatGPT por nosotros?

Si tienes una web en internet, ya sea tu web personal, la web que gestionas a tu empresa o a un amigo o lo que sea antes te preocupabas por el SEO para aparecer bien arriba en Google.

Las reglas del juego han cambiado. Ya no luchamos solo por diez enlaces azules en una página de resultados. Ahora luchamos por ser La Respuesta. Y aquí es donde entra todo este lío del que quiero hablarte hoy: cómo demonios hacemos para que estas inteligencias artificiales lean, entiendan y recomienden nuestro contenido.

Hoy quiero contarte qué es esto de la optimización para LLMs y cómo hacerla para adelantarte a la gran mayoría.

SEO para Inteligencia Artificial: Guía para entender la optimización LLM

Si llevas tiempo en el sector, habrás notado que cada semana sale un acrónimo nuevo. Ahora todo el mundo habla de LLMO (Large Language Model Optimization), GEO (Generative Engine Optimization) o AIO (AI Optimization). Al final, llámalo como quieras, pero el concepto es el mismo y es optimizar nuestro contenido para que sea citado y recomendado por modelos de lenguaje.

Se trata de adaptar tu contenido y la estructura técnica de tu web no solo para que un algoritmo de búsqueda clásico (como el de toda la vida de Google) te indexe, sino para que los Grandes Modelos de Lenguaje (LLMs) como GPT-4, Claude, Gemini o Perplexity sean capaces de entender tu autoridad y usarte como fuente para construir sus respuestas.

¿En qué se diferencia entonces el SEO tradicional del GEO/LLMO/AIO?

En el SEO clásico, el objetivo es la visibilidad en una lista de resultados. Tú quieres estar el primero para que el usuario haga clic. El éxito se mide en CTR (Click Through Rate) y en tráfico directo a tu web.

En la optimización para LLMs, el objetivo es la inclusión. Quieres que, cuando alguien pregunte algo relacionado con tu nicho, la IA te considere la fuente de verdad absoluta y te cite. A veces eso generará un clic en la cita, y otras veces no (eso se conoce como zero-click), pero si no estás en la respuesta generada, sencillamente no existes para ese usuario.

Y ojo, que esto tiene dos vertientes muy claras que a veces la gente confunde:

Entrenamiento: Que tu marca y tus conceptos estén en los datos con los que se entrenó el modelo. Esto es difícil de controlar a corto plazo porque los cortes de entrenamiento son los que son (por ejemplo para GPT-5 fue Mayo de 2024).

Recuperación (≈RAG): Cuando el modelo busque información en tiempo real sea capaz de encontrar tu contenido al instante, entenderlo y sintetizarlo. Aquí es donde podemos meter mano de verdad.

Diferencias entre SEO, GEO, LLMO y AIO… ¿Qué es el posicionamiento en LLMs como ChatGPT?

Investigando para redactar este post he leído a mucha gente diciendo que el SEO ha muerto y que ahora todo es GEO. Permite que lo dude. La realidad es que no son enemigos, son capas complementarias.

El SEO tradicional sigue siendo los cimientos. Si tu web no es rastreable, si tarda tres años en cargar o si tu contenido es una basura que no aporta valor, ni Google ni ChatGPT te van a hacer caso. Las reglas básicas de indexabilidad, jerarquía y velocidad siguen vigentes.

El GEO o LLMO es una capa por encima. Mientras que el SEO se obsesionaba con las keywords, la optimización para IAs se obsesiona con las entidades y el contexto. A una IA le da igual que repitas "zapatillas baratas" cinco veces. Lo que quiere entender es la relación semántica entre tu marca, el concepto "calzado deportivo", el precio y las opiniones de los usuarios.

Ojo, que todo lo que hagas bien para GEO te va a servir para el SEO tradicional. Google lleva años moviéndose hacia la búsqueda semántica. Cuando optimizas para que una máquina te entienda mejor (estructura clara, datos estructurados, respuesta directa a la intención), inevitablemente estás mejorando tu posicionamiento clásico.

Hay un hot take rondando por ahí con el que estoy bastante de acuerdo y es que en realidad, estamos redescubriendo el SEO. Muchas de las nuevas técnicas de GEO son simplemente buenas prácticas de SEO que habíamos olvidado.

Entonces, ¿qué hago? Tienes que dejar de escribir para robots tontos que cuentan palabras y empezar a escribir para robots listos que entienden conceptos. Ahora es cuando viene el cómo

¿Cómo hago que mi web aparezca en ChatGPT? 8 estrategias de optimización GEO

La pregunta de oro. He preparado una pequeña lista de conceptos que deberías conocer y trabajar si quieres que tu web aparezca y sea recomendada por LLMs. La última igual te sorprende…

1. Cómo construir autoridad de marca mediante el uso de entidades

Olvídate de las keywords exactas por un momento como se hacía en el SEO. Las IAs piensan en entidades (conceptos, objetos, personas o lugares) y cómo se relacionan entre sí.

Tu trabajo es asegurarte de que la IA asocia tu marca con las entidades correctas de tu sector. Si vendes software de contabilidad, no basta con poner software contabilidad en el H1. Tienes que hablar de impuestos, facturación, modelos tributarios, autónomos… y asegurarte de que tu marca aparece en ese contexto de forma natural.

¿Cómo se hace esto? Pues con consistencia. Asegúrate de que en tu web, en tus redes sociales y en cualquier sitio donde se te mencione, se usen los mismos términos para definirte. Quieres que el grafo de conocimiento de Google (y por tarto, el de las IAs) tenga una línea sólida conectando tu nombre con tu nicho.

2. Facilita la legibilidad para LLMs usando H1, H2 y H3

Los LLMs, cuando leen tu web mediante técnicas de RAG (Retrieval-Augmented Generation), suelen trocear el contenido para procesarlo. Si tu estructura de encabezados es un caos, la IA se pierde. Necesitas una jerarquía impecable.

H1: El tema principal.

H2: Los subtemas grandes.

H3: El detalle específico.

Esto ayuda a la IA a entender qué parte del texto responde a qué pregunta. Si escribes bloques de texto interminables sin pausas ni títulos, estás haciendo que sea mucho más difícil para la máquina extraer la clave de la información que busca. Pónselo fácil.

3. ¿Cómo hacer que mi contenido sea citado por la IA? Featured Snippets

Fíjate en cómo preguntamos ahora: ¿Cuál es la diferencia entre X e Y? o ¿Cómo configuro X? No dejan de ser preguntas en lenguaje natural.

Tu contenido debe atacar esas preguntas de forma explícita. Una buena técnica es incluir la pregunta literal en un H2 y responderla de forma concisa (2-3 frases) justo debajo, antes de enrollarte con la explicación larga.

Esto no solo te ayuda con los Featured Snippets de Google de toda la vida, sino que también es probable que una IA coja ese párrafo y lo escupa tal cual en su respuesta generada. Intenta ser la definición de diccionario que la IA quiere encontrar.

4. Usa el marcado Schema.org para que las IAs te entiendan y posicionen mejor

Si el HTML es el cuerpo de tu web, el Schema es la estructura que dice quién eres y qué haces. Aunque los LLMs son muy listos leyendo texto, el marcado de Schema.org les da la información ya masticada.

Usa Article, FAQPage, Product, Organization... todo lo que aplique. Especialmente el de Organization y Person para reforzar lo que hablábamos antes de las entidades. Cuanto más fácil le hagas a la máquina entender que ese número es un precio y esa fecha es un evento, más probabilidades tienes de salir referenciado correctamente.

5. Estrategias de Brand Awareness para aparecer en respuestas generadas por IA

Aquí entra lo que está fuera de tu web. Las IAs se fían de lo que dicen otros. Si hay foros, artículos de prensa o discusiones en Reddit que mencionan tu marca como una solución fiable, eso es oro puro para los LLMs.

No se trata de conseguir el enlace dofollow con el anchor text exacto como en SEO. Se trata de que tu marca aparezca en la misma frase que "mejor herramienta de X" en sitios de terceros. Fomenta que se hable de ti, que se generen conversaciones reales. El "Brand Awareness" es el nuevo Link Building.

6. Asegúrate que los bots de IA puedan leer tu contenido: Server Side Rendering (SSR) vs Client Side

Las IAs tienen un presupuesto de rastreo (crawl budget) y una paciencia limitados. Si tu web tarda la vida en cargar o depende de un JavaScript que se ejecuta en el cliente para mostrar el texto, tienes un problema.

Muchos bots de IA no ejecutan JS tan bien como Googlebot, o simplemente no lo hacen para ahorrar costes. Si tu contenido está oculto tras un <div> que se carga por AJAX a los 3 segundos, para la IA tu página está en blanco. Usa Server Side Rendering (SSR) o generación estática siempre que puedas. Texto plano, HTML limpio, rápido.

7. ¿Cómo configurar el robots.txt para permitir acceso a los bots de IA como GPTBot o CCBot?

De nada sirve todo lo anterior si tienes la puerta cerrada. Tienes que revisar tu archivo robots.txt.

Muchos administradores de sistemas, por miedo o precaución, bloquearon bots como GPTBot o CCBot desde hace tiempo. Si haces esto, estás explícitamente diciéndole a OpenAI o a Anthropic: "No quiero que leas mi contenido". Y si no lo leen, no pueden usarlo para responder preguntas sobre ti (al menos mediante RAG).

Yo mismo hice la prueba en mi web personal. En lvrpiz.com/robots.txt tengo configuradas reglas específicas. Hubo un momento en que bloqueé todo para probar, y el tráfico referenciado desde IAs cayó a cero. Ahora, de forma consciente, permito el acceso a los bots que me interesan. Si quieres saber cómo evitar que los bots de IA vean tu contenido te lo cuento más adelante.

8. ¿Qué es el archivo llms.txt y cómo crear uno para tu web?

Existe una propuesta reciente (impulsada por gente como Jeremy Howard) para estandarizar un archivo llamado llms.txt. Ojo, no lo confundas con llm.txt o variantes raras. La idea es tener un archivo en la raíz de tu dominio (como lvrpiz.com/llms.txt) que sirva como un índice curado específicamente para IAs.

Esto no es un estándar oficial. No sabemos a ciencia cierta si OpenAI o Google lo están usando activamente para priorizar contenido ahora mismo. Peeero, he visto casos de uso muy interesantes.

La idea es sencilla. En este archivo pones enlaces a versiones en Markdown de tu contenido más importante. Es como darle un resumen a la IA de qué trata tu contenido y donde encontrar cada cosa.

Hay desarrolladores que han implementado esto y han notado que, al usar herramientas de IA que navegan por la web, estas encuentran la información mucho más rápido y con menos alucinaciones. No perdemos nada por crearlo. De hecho, puedes pedirle a ChatGPT que te genere la estructura basándose en tu sitemap. Es un esfuerzo mínimo y Claude, Vercel o Stripe lo usan en su propia web!!

Las 3 herramientas gratuitas imprescindibles que uso para monitorizar el SEO en LLMs

No hace falta que te gastes un dineral en herramientas de pago para empezar con esto. De hecho, las mejores fuentes de datos siguen siendo las oficiales.

Google Search Console: Aquí ves si Google te está indexando bien. Y aunque sea de Google, si no estás indexado aquí, difícilmente lo estarás en otros lados. Fíjate bien en la pestaña de "Rastreo" y en los errores de datos estructurados. [Guía]

Google PageSpeed Insights: La velocidad es clave. Esta herramienta te dice exactamente qué scripts están bloqueando el renderizado. Si tienes una puntuación roja aquí, estás poniéndoselo difícil a los bots. [Guía]

Bing Webmaster Tools: Mucha gente se olvida de Bing (normal jajaj😅) pero Bing es el motor que alimenta a ChatGPT en su modo navegación y a Microsoft Copilot. Tener tu web verificada y sana en Bing es crítico para el GEO. No lo descuides. [Guía]

Hay muchas otras herramientas de pago que te analizan la semántica y tal, pero sinceramente, domina estas tres primero. Son la base.

¿Cómo bloquear bots de IA para que ChatGPT, Claude, Gemini… no use los datos de mi web?

¿Y si no quiero que ChatGPT vea mi web? Si ese es tu caso, aquí tienes tres trucos, pero ya te aviso que es una batalla complicada.

1. Por qué el Robots.txt no garantiza la privacidad de tus datos

A ver, el robots.txt es como una señal de Prohibido el paso en mitad del campo. La gente educada que serían los bots buenos como Googlebot o GPTBot la respetan. Pero los bots maliciosos o las empresas que van a saco se la saltan a la torera.

El robots.txt no es una orden, es una recomendación!

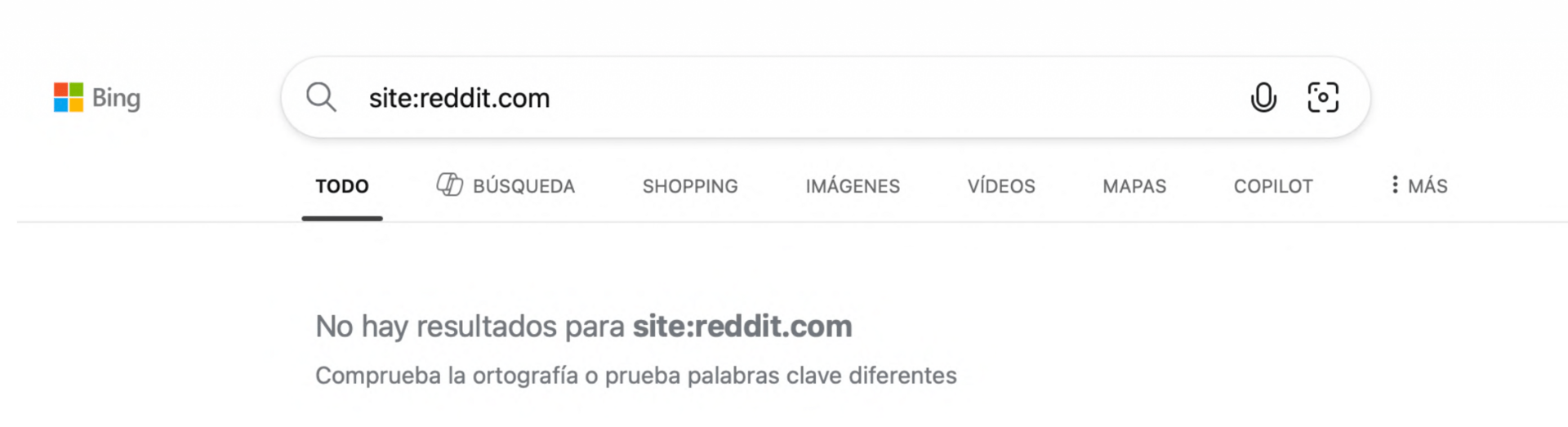

Mira el caso de Reddit. Es brutal. Reddit decidió bloquear a todo el mundo en su robots.txt para proteger sus datos. Bloquearon a Bing, a DuckDuckGo...

Robots.txt de reddit.com

¿El resultado? Esos buscadores dejaron de indexar sus hilos. Sin embargo, Google sigue indexando Reddit. ¿Por qué? Pues porque Google pagó un acuerdo de 60 millones de dólares para tener acceso a su API y a sus datos en tiempo real.

Resultados de búsqueda en Bing al buscar reddit.com

Esto nos enseña que el robots.txt funciona para los que juegan limpio, pero si hay dinero de por medio o acuerdos por detrás, el papel se moja.

2. Cómo usar Cloudflare AI Crawl Control para bloquear bots de IA

Si usas Cloudflare (que deberías), tienen una herramienta maravillosa llamada AI Crawl Control. Es un botón que te permite bloquear con un clic a todos los bots de IA conocidos. Cloudflare actualiza la lista constantemente, así que no tienes que andar peleándote con User-Agents nuevos cada semana.

Para probar su funcionamiento activé esta opción para mi web personal y le pedí a chatGPT que me leyera el contenido de mi web:

Consulta a chatGPT por lvrpiz.com fallida

Como ves al estar activada esta opción ChatGPT ni Gemini ni ningún bot de IA puede acceder a los recursos de mi web (en teoría). En cambio si desactivo esta opción mira lo que ocurre:

Consulta a chatGPT por lvrpiz.com exitosa

3. ¿Cómo proteger tu servidor de peticiones excesivas de bots de IA con Rate Limiting de Cloudflare?

Si no quieres bloquearlos del todo, pero tampoco quieres que te tumben el servidor escaneando tu web a mil por hora puedes configurar reglas de Rate Limiting con algo como: "Si una IP me pide más de 10 páginas en 1 minuto, bloquéala durante una hora". Esto frena a los scrapers agresivos que alimentan modelos de IA sin permiso.

Si un bot (o un humano) cumple con la regla verá una pantalla como esta que seguro que has visto más de una vez:

Rate limiting de Cloudflare de acción

Piensa que la optimización para LLMs es la evolución natural de cómo los humanos buscamos información. Hemos pasado de buscar palabras clave en Google a hacer preguntas completas y más complejas a un LLM.

Si tienes una web no hace falta que lo implementes todo mañana. Te recomendaría tener una buena base de SEO, asegurarte que tu web está indexada y sin problemas en Bing y probar alguno de los 8 consejos que te comentaba previamente para mejorar el contenido.

Los que se posicionen ahora como fuentes de autoridad en este nuevo mundo se van a llevar una ventaja competitiva cuando esto se estandarice del todo.